NVIDIA的Blackwell是什么,为什么你应该了解它?- 了解NVIDIA的Blackwell的重要性

Blackwell GPU架构引入了六项创新技术,用于加速计算。预计将催化数据处理的改进。

Nvidia的Blackwell:2024年3月18日,Nvidia首席执行官Jensen Huang在GTC 2024主题演讲中宣布了Nvidia Blackwell平台的到来。据这家芯片制造巨头称,Blackwell平台可以使全球的组织部署和运行使用万亿参数大型语言模型的实时生成式AI,同时与前一代相比,成本和能耗降低高达25倍。

Blackwell GPU架构引入了六项创新技术,用于加速计算。预计将催化数据处理、工程模拟、电子设计自动化、计算机辅助药物设计、量子计算和生成式AI等领域的改进——所有这些都代表着NVIDIA蓬勃发展的行业前景。在这份报告中,我们将深入探讨Nvidia全新的GPU架构带来的升级,并分析它将如何在未来几年影响AI领域。

什么是Nvidia的Blackwell?

Blackwell是Nvidia最新的图形处理单元(GPU)微架构,继承了Hopper和Ada Lovelace设计。为了纪念著名统计学家和数学家David Blackwell,Nvidia在2023年10月的投资者介绍会上正式宣布了Blackwell系列的B100和B40型号。正如公司路线图中所概述的那样。

Blackwell架构的正式发布是在2024年3月18日的Nvidia GTC 2024主题演讲中。在发布活动中,Nvidia首席执行官Jensen Huang将Blackwell描述为“为生成式AI时代量身定制的处理器”,强调了它在新兴人工智能领域的潜在作用,这个领域迫切需要更高效的图形处理单元。“目前没有任何硬件比NVIDIA更适合AI。”——埃隆·马斯克

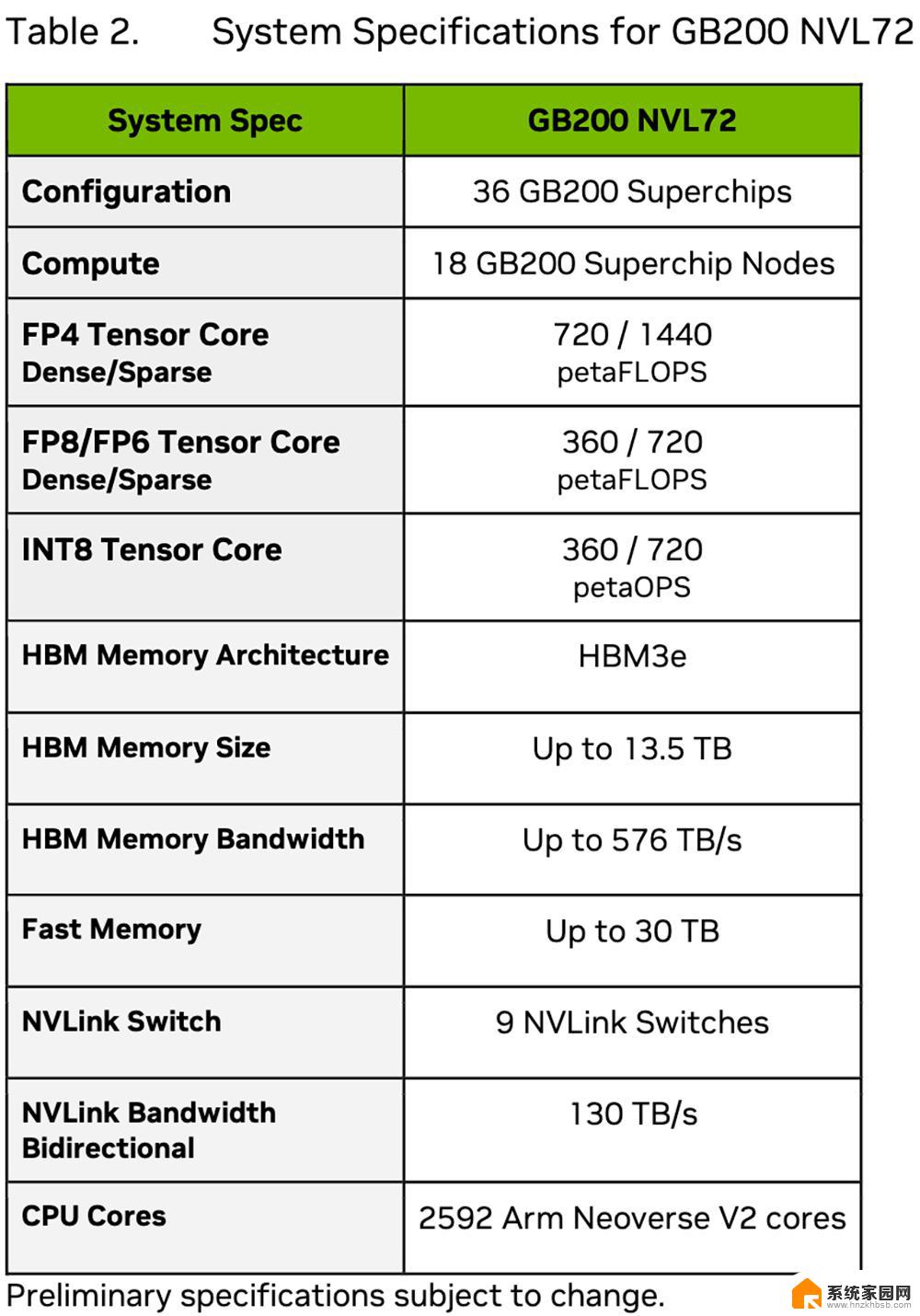

Blackwell的架构旨在满足数据中心计算应用、游戏和工作站需求,每个目的都有专用的芯片。GB100芯片针对Blackwell数据中心产品,而GB200系列芯片则预留给即将推出的GeForce RTX 50系列显卡。

以下是Nvidia的Blackwell GPU推出的一些主要架构进步。这些更新将把人工智能计算提升到一个新的水平,使发展比以往任何时候都更接近人工通用智能。

处理能力巨头

Blackwell架构GPU将配备2080亿个晶体管。晶体管是电子设备的基本单位,这些GPU内部晶体管的数量之多,凸显了其非凡的处理能力。GPU内部晶体管数量越多,其执行复杂计算的能力就越强,速度和效率也越高。

这些GPU使用定制的4NP TSMC工艺制造,这是台湾半导体制造公司(TSMC)的专长。GPU还集成了芯片间链接机制,促进单个GPU芯片之间的无缝通信。以10TB/秒的速度,这种芯片间链接使得高效的数据传输成为可能,允许GPU作为一个统一的整体运作。

第二代变换引擎

新的GPU引擎受益于微张量缩放支持和NVIDIA的动态范围管理算法,这些算法集成到了像TensorRT-LLM和NeMo Megatron这样的框架中。

这些更新使Blackwell能够支持双倍的计算和模型大小,同时引入了4位浮点AI推理能力,提高了整体AI性能。

这意味着AI开发者可以处理更大、更复杂的模型,在他们的应用中实现更高的准确性和复杂性。

对于需要大量数据和计算资源的复杂语言和多模态模型,这种无缝通信对于加速训练和推理过程至关重要。

改进的NVLink促进了更快的模型收敛、更高的准确性和更复杂的AI应用,推进了AI模型有效应对现实世界挑战的能力。

RAS引擎

Blackwell动力GPU具有一个专门的引擎,用于可靠性、可用性和可维护性(RAS)。此外,架构在芯片级别集成了基于AI的预防性维护能力,使得诊断和可靠性预测成为可能。这些功能最大化了系统的正常运行时间,提高了弹性,并降低了运营成本,对于大规模AI部署至关重要。

Blackwell还支持新的加密协议,以确保数据隐私,这对于像医疗保健和金融服务这样的行业尤为重要,数据保护至关重要。

Blackwell的解压缩引擎通过支持最新的数据格式,加速了数据库查询。这一增强功能提升了数据分析和科学领域的性能,与GPU加速数据处理的增长趋势相一致,这对公司来说意味着显著的效率提升和成本节约。

NVIDIA的Blackwell是什么,为什么你应该了解它?- 了解NVIDIA的Blackwell的重要性相关教程

- NVIDIA斥巨资为即将推出的Hopper H200和Blackwell B100订购HBM3E内存:最新内存技术助力显卡性能突破

- 独立显卡是什么意思?一文带你了解独立显卡的作用

- NVIDIA B100 'Blackwell' GPU 2024年Q4发布,采用3纳米工艺制造

- CPU、TPU和GPU有什么区别?一文带你了解三者的差异

- 抢位AI AMD的那些神之一手,让你了解AMD处理器的性能优势

- 显卡揭秘:为什么游戏中流畅画面离不开它?解析你必须知道的关键因素

- NVIDIA在中国的新难题:客户不想要降级芯片,如何应对?

- 为什么家里的wifi连接了却用不了 WIFI连得上但用不了怎么办

- AMD Zen5越来越近:AM5 600系主板全都能升级!你需要了解的一切

- NVIDIA 人工智能开讲 | NVIDIA NIM 再升级!——全面解读NVIDIA最新技术创新

- Nvidia将在美国量产AI超级计算机,助力人工智能领域创新发展

- 英伟达RTX 5060系列显卡发布:性能和价格揭秘

- Windows搜索神器Everything,秒杀自带搜索,快速定位文件,秒搜不必等

- 仁宝、纬颖和美国捷普竞购AMD服务器工厂资产,谁将成功收购?

- 国产CPU竞速信创,对数码科技行业是好生意?

- 迈入计算加速新时代 第二代AMD Versal Premium系列上新,助力您的计算体验提速

微软资讯推荐

- 1 Nvidia将在美国量产AI超级计算机,助力人工智能领域创新发展

- 2 英伟达RTX 5060系列显卡发布:性能和价格揭秘

- 3 Windows搜索神器Everything,秒杀自带搜索,快速定位文件,秒搜不必等

- 4 国产CPU竞速信创,对数码科技行业是好生意?

- 5 如何查看电脑显卡型号及性能信息的方法,详细教程揭秘

- 6 CPU厂商的新一轮较量来了!AMD、英特尔谁将称雄?

- 7 英伟达发布NVIDIA app正式版 带来统一GPU设置软件,让你轻松管理显卡设置

- 8 详细指南:如何在Windows系统中进行激活– 一步步教你激活Windows系统

- 9 国产显卡摩尔线程筹备上市,国产显卡即将登陆市场

- 10 详细步骤教你如何在Win7系统中进行重装,轻松搞定系统重装

win10系统推荐

系统教程推荐