微软和OpenAI也要自研芯片,都想做躺赚的英伟达:芯片领域新势力崛起

据知情人士透露,微软方面计划在下月举行的年度开发者大会上推出旗下首款为人工智能设计的芯片,来降低成本、并减少对英伟达的依赖。据称微软的这款自研芯片将用于数据中心、服务器,其为训练大语言模型(LLM)等软件而设计,同时可支持推理,能为所有AI软件提供动力。

同一时间,OpenAI也被曝出正在探索自研AI芯片,同时也开始评估潜在的收购目标。而且在招聘网站上,OpenAI已在招募硬件工程师。再加上早已开始自研专用集成电路(ASIC)芯片的谷歌、亚马逊、Meta,目前海外AI赛道的主要参与者几乎是全数下场自研AI芯片了。毕竟如今在AI这条赛道中,算力焦虑就犹如达摩克利斯之剑,一直高悬在各大厂的头顶。

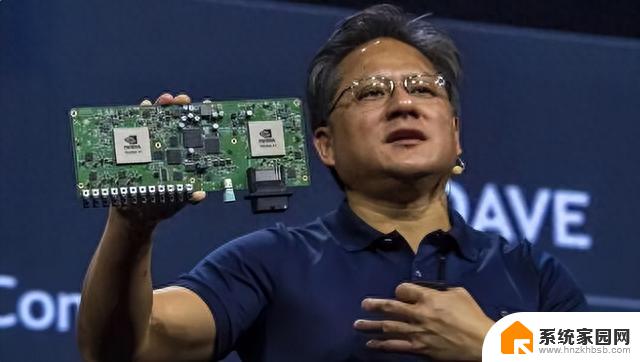

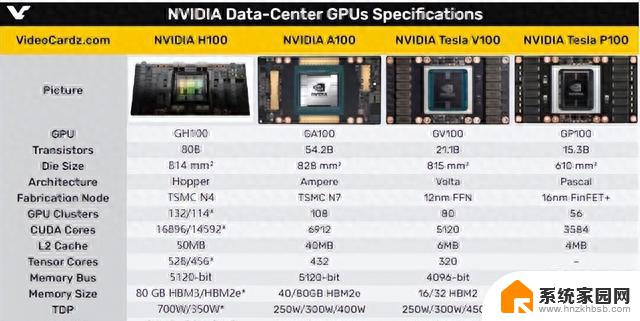

如果说石油被称为“工业的血液”,那么英伟达的Ampere A100、Hopper H100加速卡现阶段无疑就是AI的血液。目前,运行ChatGPT的微软数据中心服务器里有数以万计的A100在工作。而作为市面上性能最强的AI算力芯片,更先进的H100即使有着高达4万美元的价格,自上市以来也一直处于供不应求的状态。

从国内市场的百度、字节跳动、腾讯和阿里巴巴,到海外的微软、亚马逊,英伟达的GPU已经在事实上成为了AI领域的硬通货。这样的局面更是让英伟达从GPU制造商转型为AI领域最有权势的投资机构之一,而这个行业对于英伟达GPU的依赖性,也使得大家纷纷倾向于选择他们的投资。

根据英伟达方面在8月中旬公布的2024财年第二季度财报显示,该季度其营收额达到了135亿美元,其中数据中心业务营收实现了创纪录的103.2亿美元,仅这一个季度就翻了一倍多。按照英伟达自己的解释,市场对生成式AI芯片前所未有的需求抵消了PC市场对GPU需求萎缩的冲击。自今年以来,英伟达的股价涨幅已接近230%,所以从某种意义来说,这家公司就是“AI浪潮本浪”。

科技巨头以及AI创业者对于算力的追求让英伟达赚得盆满钵满,这一现状在目前各大厂商暂时没有找到一个合适商业模型的情况下,更是显得尤为突出。当年虚拟货币火的时候,英伟达靠给矿工卖显卡赚了大钱,现在AI走红,英伟达又继续给AI厂商卖加速卡获利,这又怎能不让微软、OpenAI等厂商眼热呢?

既然从本质上来说,ChatGPT这类大型语言模型就是“大力出奇迹”,毕竟神经网络的层数多了、参数规模大了、语料丰富了,“智能”也就随之涌现。根据市场调查机构TrendForce在今年3月初的推算显示,如果以半精度浮点算力为311.88 TFLOPS的英伟达Ampere A100来计算,运行算力消耗高达3640PF-days的ChatGPT,需要至少3万片A100才能让这个模型运转起来。

所以微软和OpenAI自研AI芯片也是个很正常的选项,毕竟微软财大气粗,OpenAI更是一众投资机构挥舞着钞票要投的对象,两者都不差钱。

那么问题就来了,AI赛道的顶级玩家纷纷自研AI芯片,会动摇目前英伟达的地位吗?

如果微软、Meta、谷歌、OpenAI愿意付出代价,英伟达的好日子确实可能就要到头了,但这个代价或许有点大。

自研AI芯片并不难,但要将AI芯片转化为算力却不容易,要不同样是GPU厂商的AMD怎么就没吃到这一轮红利呢。还不是因为目前AI行业高度依赖英伟达的CUDA生态,而CUDA则只能用英伟达自家GPU的并行计算框架。换而言之,硬件层面追赶英伟达或许不难,可问题的实质是如何在软件生态层面填平他们的护城河。

经历了过去十余年的积累,英伟达的CUDA在库、工具和资源生态系统提供了丰富的工具。使得开发者能够轻松借助GPU的并行计算能力,构建更强大和高效的AI模型,同时也是实现高性能、高通用性、高易用性,以及针对不同应用场景深度优化的关键所在。更妙的是,CUDA是软硬件结合的桥梁,它既是英伟达软件生态的基座,也是其硬件形态的软件抽象。

由于英伟达这一护城河过于成功,以至于解决英伟达在AI算力领域的垄断的方式,是在CUDA之外另起炉灶,可这一策略要直面用户粘性的难题。退而求其次的做法则是兼容CUDA,但这会导致硬件生态必须走英伟达的路线。所以显而易见的是,无论哪一条道路,代价都是极其惊人的。

当然,AI大厂集体炒作自研芯片,在某种意义上也可以被视为是对英伟达的一次“逼宫”,是要逼迫英伟达将超额利润吐出来的策略也说不定。

微软和OpenAI也要自研芯片,都想做躺赚的英伟达:芯片领域新势力崛起相关教程

- 微软自研AI芯片,摆脱英伟达,媒体称自主研发是大势所趋

- 英伟达大客户微软:“AI芯片荒”正在改善,行业迎来新变革

- AMD新款AI芯片硬刚英伟达,推理性能比H200高出40%

- 微软深夜发布100更新:人人定制Copilot,自研两款AI芯片

- 英伟达NVIDIA摘得芯片行业收入桂冠!在芯片行业中取得最高收入,成绩斐然!

- 新AI芯片B200推迟上市,对英伟达影响有多大?解析:英伟达股价或将受到影响

- 英伟达封杀功能:国产GPU芯片厂商是否借鸡生蛋?

- 英伟达停止接收H20芯片订单,消息传出后引发市场关注

- 英伟达发布全球最强AI芯片H200:性能较H100提升近一倍,引领人工智能技术发展

- 英伟达新芯片”延期”?别慌,影响没那么大,详细解析延期对市场的实际影响

- Nvidia将在美国量产AI超级计算机,助力人工智能领域创新发展

- 英伟达RTX 5060系列显卡发布:性能和价格揭秘

- Windows搜索神器Everything,秒杀自带搜索,快速定位文件,秒搜不必等

- 仁宝、纬颖和美国捷普竞购AMD服务器工厂资产,谁将成功收购?

- 国产CPU竞速信创,对数码科技行业是好生意?

- 迈入计算加速新时代 第二代AMD Versal Premium系列上新,助力您的计算体验提速

微软资讯推荐

- 1 Nvidia将在美国量产AI超级计算机,助力人工智能领域创新发展

- 2 英伟达RTX 5060系列显卡发布:性能和价格揭秘

- 3 Windows搜索神器Everything,秒杀自带搜索,快速定位文件,秒搜不必等

- 4 国产CPU竞速信创,对数码科技行业是好生意?

- 5 如何查看电脑显卡型号及性能信息的方法,详细教程揭秘

- 6 CPU厂商的新一轮较量来了!AMD、英特尔谁将称雄?

- 7 英伟达发布NVIDIA app正式版 带来统一GPU设置软件,让你轻松管理显卡设置

- 8 详细指南:如何在Windows系统中进行激活– 一步步教你激活Windows系统

- 9 国产显卡摩尔线程筹备上市,国产显卡即将登陆市场

- 10 详细步骤教你如何在Win7系统中进行重装,轻松搞定系统重装

win10系统推荐

系统教程推荐