微软开源1bit大模型推理框架,千亿参数模型量化后单CPU可轻松运行

西风 发自 凹非寺

量子位 | 公众号 QbitAI

微软开源1bit大模型推理框架!

现在1000亿参数大模型量化后单CPU可跑,速度可达每秒5-7个token。

就是今年爆火论文The Era of 1-bit LLMs的官方代码实现,开源不到一周GitHub已揽获7.9k Star。

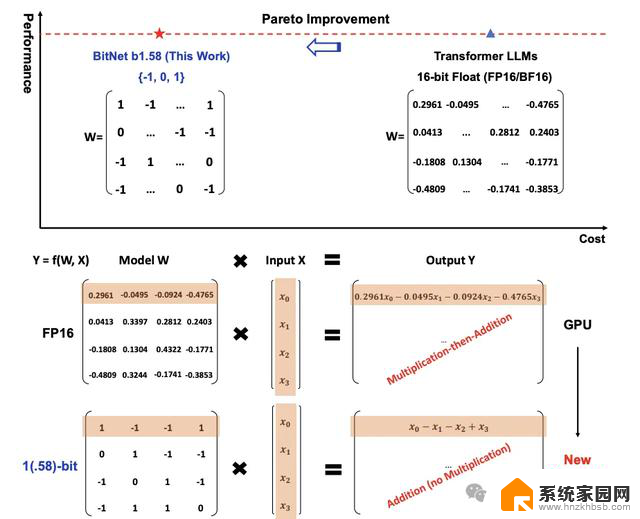

传统大模型参数以16位浮点数(如FP16或BF16)形式的存储,而BitNet b1.58将其统统变成了三进制,也就是 {-1, 0, 1}。

这里的“1.58 bit”指每个参数可以用1.58位的信息来表示。

转换之后,矩阵中的计算就只会涉及到加法。因此会让大模型在保持一定精度的同时,显著减少所需的存储空间和计算资源,也显著提升了在本地设备上运行LLM的可能性。

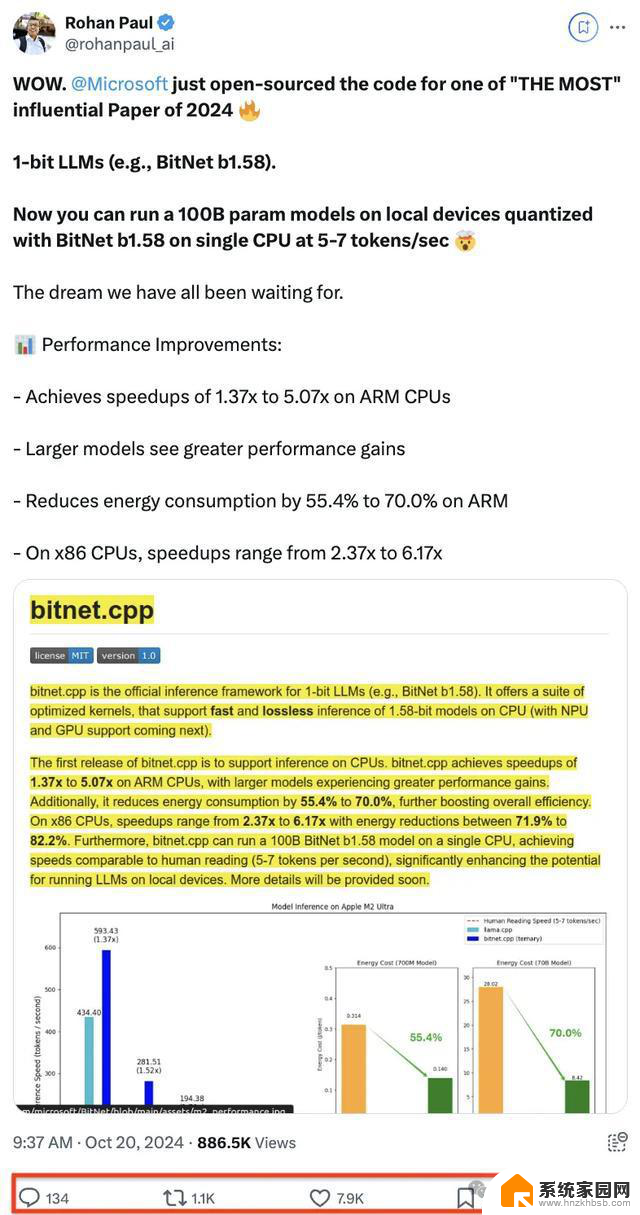

这个项目开源后,在X上也受到了一波高度关注。

千亿参数模型量化后单CPU可跑

千亿参数模型量化后单CPU可跑bitnet.cpp是1bit LLM(例如 BitNet b1.58)的官方推理框架。

该框架配备了一系列优化内核,支持在CPU上进行快速且无损的1.58bit模型推理,未来将扩展支持NPU和GPU。

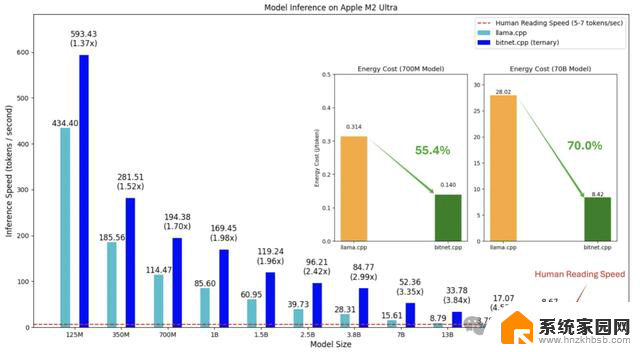

bitnet.cpp的首版主要支持CPU推理。

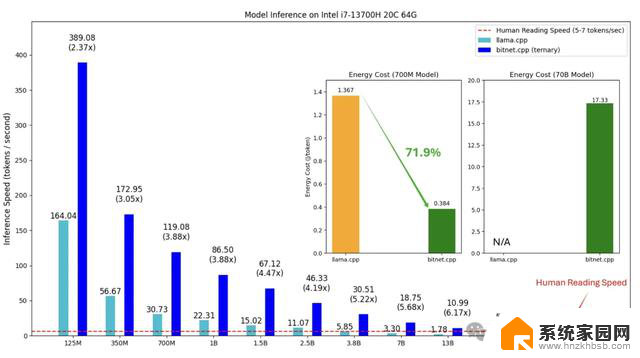

具体性能改进方面,在ARM CPU上,该框架可实现1.37至5.07倍的加速,而且更大的模型将有更显著的性能提升。

同时,它能将能耗降低55.4%至70.0%,进一步增强效率。

在x86 CPU上,加速效果介于2.37至6.17倍之间,能耗减少71.9%至82.2%。

网友们也发现了华点,在x86上的性能增益量比ARM更大。

此外,bitnet.cpp能使千亿参数模型量化后单CPU可跑,速度可达每秒5-7个token,接近人类阅读速度。

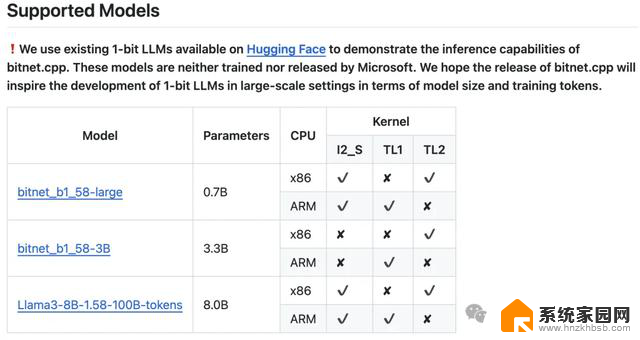

微软还展示了使用bitnet.cpp推理框架支持的不同1 bit LLM。

6页论文,引入1 bit LLM

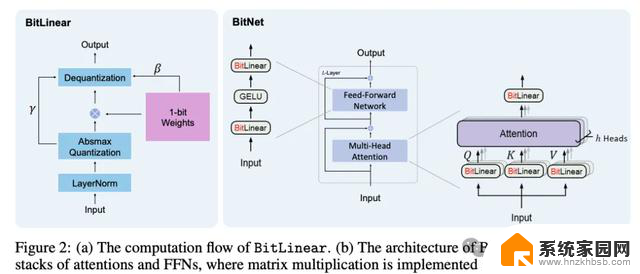

6页论文,引入1 bit LLM1 bit LLM的实现方法,微软在一年前就有相关研究,称为BitNet(一种Transformer),用BitLinear替换了nn.Linear。

今年二月,BitNet原班人马在上一篇论文的基础之上做了优化,提出BitNet b1.58,在原始BitNet的基础上增加了一个额外的0值。

然后这篇内容只有6页的论文引发热议:

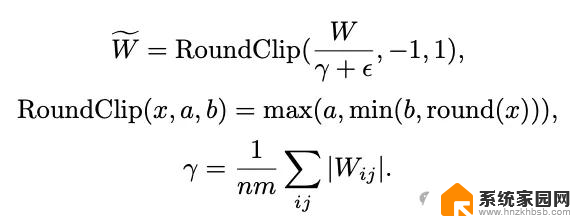

BitNet b1.58模型的权重被量化为三元值{-1, 0, 1},相当于在二进制系统中使用了1.58 bit来表示每个权重。

采用了absmean量化函数来约束权重,将权重矩阵通过其平均绝对值进行缩放,然后四舍五入到最接近的整数值(-1、0或1)。

激活量化中,激活值被缩放到[−Qb, Qb]的范围,以此来消除零点量化。

在架构设计上,BitNet b1.58借鉴了Llama,使用了RMSNorm、SwiGLU、旋转位置编码等组件,并移除了所有偏置项。这种设计使其能够轻松集成到主流的开源框架中。

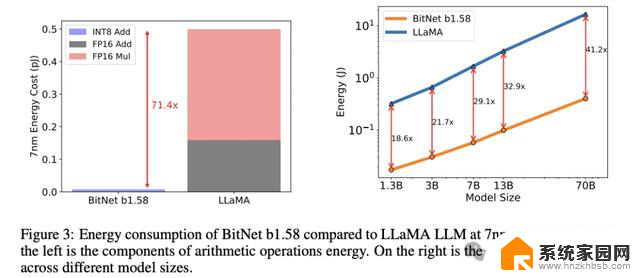

实验中,与Llama相比,BitNet b1.58在矩阵乘法方面节省了71.4倍的计算能耗。

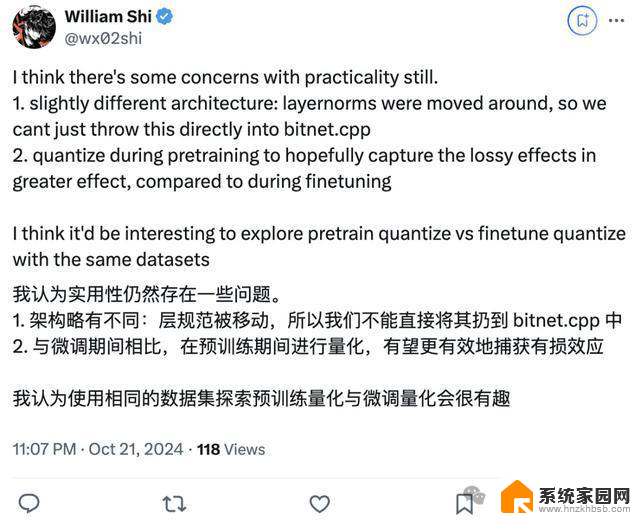

这种方法发布后,也有不少人在这项研究的基础之上进行探索。

其中一个问题是,BitNet b1.58将每个参数仅用三元值表示,但是所有这些都需要从头开始训练模型,并不是谁都有预算来进行LLM预训练。

而Huggingface Transformers最近整合了BitNet b1.58,运用了一些技巧,使得现有模型可以直接微调到1.58bit。

感兴趣的童鞋可以自行查阅。

不过也有网友指出了这种方法的局限:

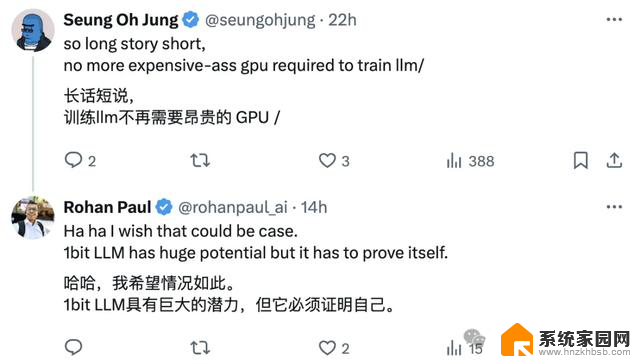

总之,1 bit LLM具有巨大的潜力。

但也正如网友所言,1 bit LLM关键还得是能在实践中证明自己。

参考链接:

[1]https://github.com/microsoft/BitNet

[2]https://x.com/rohanpaul_ai/status/1847814379657462201

[3]https://x.com/rohanpaul_ai/status/1848172443258728860?s=46&t=iTysI4vQLQqCNJjSmBODPw

[4]https://huggingface.co/blog/zh/1_58_llm_extreme_quantization

— 完 —

量子位 QbitAI · 头条号签约

关注我们,第一时间获知前沿科技动态

微软开源1bit大模型推理框架,千亿参数模型量化后单CPU可轻松运行相关教程

- 微软推出安卓版本Copilot应用 已在谷歌Play Store上架,助你驾驶更轻松!

- 大模型放进推荐系统怎么玩?微软亚研全面总结

- 集成大语言模型与产业数据智能,构建产业基础模型

- 微软、英伟达纷纷押注小模型,大模型不香了?如何解决99%的使用场景

- 微软与苹果在系统级玩家竞争中的大模型路径分析

- 微软AI大语言模型助力搜索引擎,提升企业生产力

- 英伟达产品系列分类及数据中心GPU型号参数大全

- Win11留后门!轻松打开旧版文件资源管理器的方法揭秘

- 微软员工上报OpenAI DALL-E 3模型存生成“不当内容”漏洞,遭封口令

- 微软推出超逼真对话人脸的AI模型,让虚拟交流更加生动逼真

- 七彩虹iGame RTX 5080 Ultra显卡装机测试:性能和颜值双丰收

- 微软CEO纳德拉:公司30%代码由AI编写,掀起编程革命

- NVIDIA新驱动修复41个Bug!RTX 50花式黑屏、RTX 40没人管,问题得到解决

- 技嘉RTX 5060显卡采用更短小PCB设计,配备×8 PCIe金手指

- 摩根士丹利略微下调微软的增长预期,市场对微软的未来表现持谨慎态度

- win7文件夹加密软件之易捷文件夹加密软件——您的文件安全保护利器

微软资讯推荐

- 1 NVIDIA新驱动修复41个Bug!RTX 50花式黑屏、RTX 40没人管,问题得到解决

- 2 win7文件夹加密软件之易捷文件夹加密软件——您的文件安全保护利器

- 3 Nvidia将在美国量产AI超级计算机,助力人工智能领域创新发展

- 4 英伟达RTX 5060系列显卡发布:性能和价格揭秘

- 5 Windows搜索神器Everything,秒杀自带搜索,快速定位文件,秒搜不必等

- 6 国产CPU竞速信创,对数码科技行业是好生意?

- 7 如何查看电脑显卡型号及性能信息的方法,详细教程揭秘

- 8 CPU厂商的新一轮较量来了!AMD、英特尔谁将称雄?

- 9 英伟达发布NVIDIA app正式版 带来统一GPU设置软件,让你轻松管理显卡设置

- 10 详细指南:如何在Windows系统中进行激活– 一步步教你激活Windows系统

win10系统推荐

系统教程推荐