英伟达发布全球最强AI芯片H200:性能较H100提升近一倍,引领人工智能技术发展

更新时间:2023-11-14 11:20:47作者:hnzkhbsb

快科技今日(11月14日)消息,在2023年全球超算大会(SC2023)上。芯片巨头英伟达发布了H100芯片的继任者,也是目前世界最强的AI芯片——H200。

相比于其前任产品H100,H200的性能直接提升了60%到90%。

不仅如此,H200与H100一样都是基于英伟达Hopper架构打造。这也意味着两款芯片可以互相兼容,对于使用H100企业而言,可以无缝更换成最新的H200。

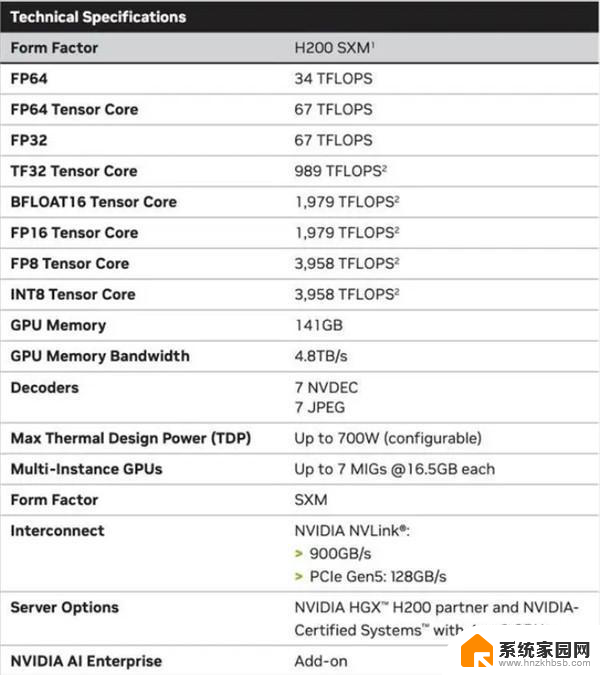

同时H200还是英伟达首款使用HBM3e内存的芯片,速度更快容量更大,更适合用于大语言模型的训练或者推理。

除了HBM3e内存外,H200的内存容量为141GB,带宽从H100的3.35TB/s增加到了4.8TB/s。

H200的性能提升最主要体现在大模型推理表现上,H200 在700亿参数的Llama2大模型上的推理速度比H100快了一倍,而且在推理能耗上H200相比H100直接降低了一半。

对于显存密集型HPC应用,H200更高的显存带宽能够确保高效地访问操作数据,与CPU相比,获得结果的时间最多可提升110倍。

英伟达表示H200预计将于2024年第二季度出货,售价还暂未公布,不过在算力荒下,大科技公司们估计还是会疯狂囤货。

英伟达发布全球最强AI芯片H200:性能较H100提升近一倍,引领人工智能技术发展相关教程

- NVIDIA发布H200芯片:AI性能翻倍,国内专供版效能远超预期

- 英伟达发布最强消费级显卡,AI 性能增长超170%

- 你追我赶!英伟达、Meta同日宣布机器人重磅成果,引领机器人技术的最新进展

- 微软和“元”增加AI投入,加速推动人工智能技术发展

- 英特尔最强服务器CPU来了!AI性能直接翻倍,性能提升显著

- AMD新款AI芯片硬刚英伟达,推理性能比H200高出40%

- 英伟达(NVIDIA):全球领先的GPU制造商和人工智能解决方案提供商

- 英国批准微软与Inflection AI交易,推动人工智能发展

- NVIDIA 人工智能开讲 | NVIDIA NIM 再升级!——全面解读NVIDIA最新技术创新

- AMD发布BIOS更新,Zen 5处理器性能与延迟全面提升 - 技术新闻最新动态

- 迈入计算加速新时代 第二代AMD Versal Premium系列上新,助力您的计算体验提速

- 如何查看电脑显卡型号及性能信息的方法,详细教程揭秘

- 微软“Microsoft自动填充Chrome扩展”插件12月14日停用,用户需寻找替代方案

- CPU厂商的新一轮较量来了!AMD、英特尔谁将称雄?

- 微软发布Windows 11 2024更新,新型Copilot AI PC功能亮相,助力用户提升工作效率

- CPU选购全攻略:世代差异、核心架构、线程数、超频技巧一网打尽!

微软资讯推荐

- 1 如何查看电脑显卡型号及性能信息的方法,详细教程揭秘

- 2 CPU厂商的新一轮较量来了!AMD、英特尔谁将称雄?

- 3 英伟达发布NVIDIA app正式版 带来统一GPU设置软件,让你轻松管理显卡设置

- 4 详细指南:如何在Windows系统中进行激活– 一步步教你激活Windows系统

- 5 国产显卡摩尔线程筹备上市,国产显卡即将登陆市场

- 6 详细步骤教你如何在Win7系统中进行重装,轻松搞定系统重装

- 7 微软停服后,Linux对俄罗斯“动手”,国产系统关键一战即将开启

- 8 英伟达RTX50系列显卡提前发布,游戏体验将迎来重大提升

- 9 微软网页版和Win11新版Outlook可固定收藏夹功能本月开测

- 10 双11国补优惠力度大,AMD锐龙HX旗舰游戏本5800元起

win10系统推荐

系统教程推荐

- 1 whatsapp显示日期不正确 whatapp手机时间不准怎么办

- 2 怎么关掉键盘声音 电脑键盘按键声音怎么调节

- 3 蓝牙耳机通话有电流声如何处理 蓝牙耳机听到电流声怎么处理

- 4 win10和win7怎样共享文件夹 Win10局域网共享问题彻底解决方法

- 5 电脑屏幕发灰 笔记本电脑屏幕颜色调整方法

- 6 win7家庭普通版个性化设置在哪里 Win7家庭版个性化设置找回方法

- 7 win11无法取消pin密码 win11怎么取消登录pin密码

- 8 win11锁屏设置在哪里设置 win11系统锁屏界面设置方法

- 9 电话怎么设置自动重拨 手机通话中断后自动重拨设置教程

- 10 怎么显示隐藏的app 苹果手机应用隐藏教程